Wpis Gościnny

Dziś chciałbym ogłosić, że pojawił się pierwszy artykuł gościnny na blogu Pushsec. Jestem z tego bardzo zadowolony ????. Artykuł ten został napisany przez Oskara Klimczuka. Jeśli i Ty masz ciekawy temat, którym chciałbyś się podzielić, to napisz. Jeśli się stresujesz lub nie wiesz, jak zacząć, nie martw się — pomogę, podeślę Ci szablon, jak to robić, siądziemy, przeanalizujemy i damy radę ;).

Także jeśli jesteś chętny bądź troszkę się boisz, to napisz do mnie przez zakładkę Kontakt. Spróbuj, nie martw się, nie gryzę ;). Nie martw się, ja będę dalej tworzył bardziej zaawansowane artykuły, ale również będę poszerzał w blogu materiały podstawowe, ponieważ nie uważam, bym je już wyczerpał. Ten artykuły zawiera podstawową wiedzę, ale była potrzeba, by się tu znalazł. Przyda się on wielu osobom.

Wstęp

W tym artykule zawarte są najważniejsze informacje odnośnie architektury sprzętowej komputera. Szczegółowo zostało opisane działanie procesora (CPU), pamięci głównej komputera (RAM), magistrali komunikacyjnej (bus), dysków HDD i SSD. Przeanalizowane zostały również bardziej skomplikowane zagadnienia, takie jak architektura wielu komputerów i architektura wirtualizacji. Dowiesz się również z niego, czym jest firmware, jak używa się powszechnie urządzeń wejścia-wyjścia (I/0), do czego służy system operacyjny (wraz z opisem plików systemowych) i jakie systemy plików są powszechnie używane. Wszystko zostało opisane w przystępny sposób, przy zachowaniu najważniejszych technicznych niuansów. Niniejszy tekst pozwoli Ci na zapoznanie się ze wspomnianymi tematami w formie lekko napisanego tekstu, dogłębnie tłumaczącego wszelkie trudne aspekty architektury sprzętowej komputera.

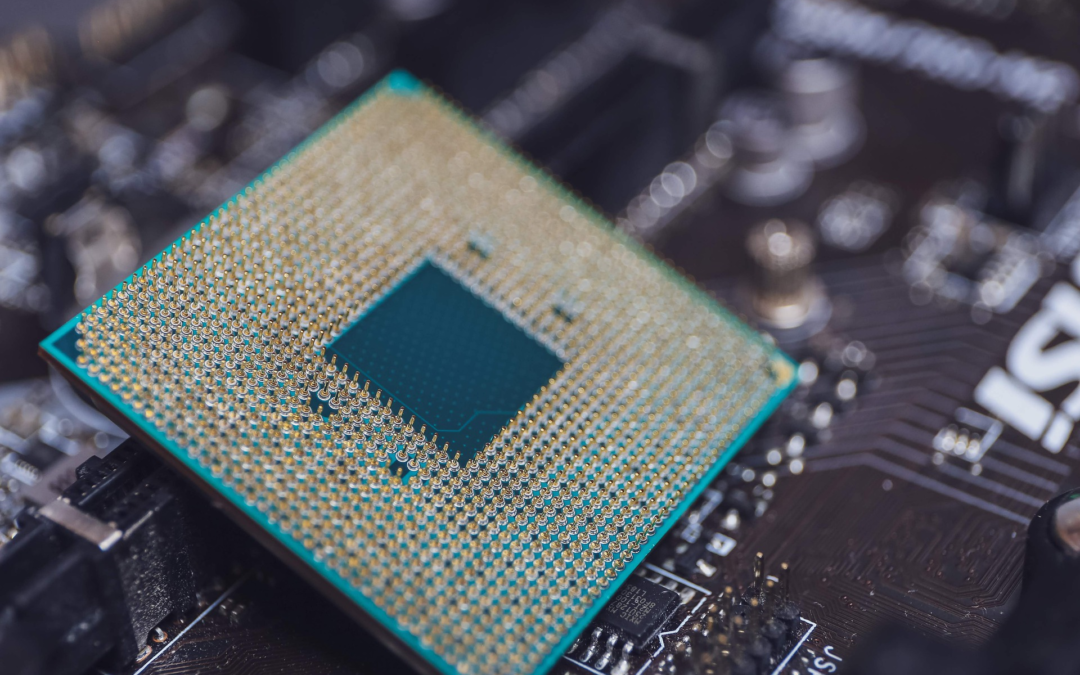

Czym jest CPU (Central Processing Unit)?

CPU – opis działania, forma pamięci

CPU to skrót od angielskiego „Central Processing Unit”. W tłumaczeniu oznacza centralną jednostkę przetwarzającą. Zarówno po angielsku, jak i po polsku, CPU nazywa się popularnie procesorem. Procesor w komputerze można porównać do mózgu u człowieka – obydwa odpowiadają za przetwarzanie informacji i wykonywanie praktycznie każdej czynności.

Podstawową funkcją działania procesora jest wykonywanie rozkazów. Procesor jest odpowiedzialny za wykonywanie obliczeń. Aktualnie w procesorach znajdują się miliardy tranzystorów, dzięki czemu możemy przeprowadzać bardzo skomplikowane obliczenia. Rozkazy wykonywane są cyklicznie, zaś cykle składają się z dwóch faz:

- Faza pobierania rozkazu — procesor dostaje informacje odnośnie adresu rozkazu w pamięci RAM, następnie wysyła go rejestru rozkazów poprzez magistralę danych

- Faza wykonania rozkazu – procesor po zlokalizowaniu polecenia przechodzi do następujących czynności, jakimi są:

- Obliczanie adresu i pobranie argumentu

- Wykonanie rozkazu – główne zadanie CPU polegające zazwyczaj na: kopiowaniu danych, wykonywaniu działań arytmetycznych, działaniu bramek logicznych bądź skoków

- Obliczanie adresu przeznaczenia i zapis wyniku

Liczbę rozkazów wykonywanych w ciągu jednej sekundy definiuje główny parametr procesora, jakim jest liczba GHz (gigaherców).

Procesor posiada również swoją pamięć. Nazywana jest CPU cache, czyli pamięcią podręczną procesora. Zazwyczaj nie jest większa niż kilkanaście MB. Przechowuje ona dane, których na bieżąco potrzebuje lub może potrzebować procesor.

ALU, IC – z czego składa się procesor?

Procesor składa się z trzech głównych układów. Są nimi:

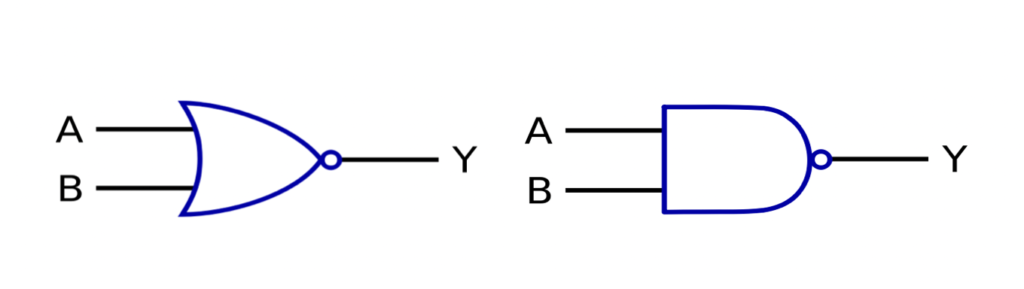

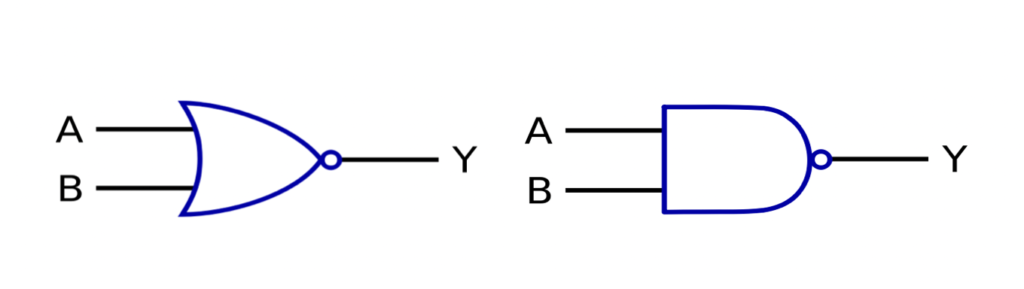

- Jednostka arytmetyczno logiczna (ALU, Arithmetic Logic Unit) – wykonuje operacje z zakresu bramek logicznych (AND, OR, XOR, NOT), mnożenia i dzielenia, dodawania i odejmowania, przesunięć bitów i innych, bardziej skomplikowanych czynności

- Układ scalony (IC, Intergrated Circuit) – półprzewodnikowy układ elektroniczny, z reguły produkowany przy użyciu monokryształów krzemu. Wykorzystywany jest w elektronice. Ma mniejsze możliwości niż procesor. Przyczynił się znacząco do miniaturyzacji sprzętów elektronicznych, ponieważ na jednym fragmencie krzemu mieści się wiele prostych elementów pasywnych.

Architektura CPU

CPU, pomimo pełnienia identycznych funkcji, różnią się metodami i zasadami działania. Do najważniejszych różnic pomiędzy głównymi architekturami zestawu instrukcji należy lista rozkazów możliwych do wykonania i typy komórek pamięci procesora. Obecnie na rynku dominują architektury CISC i RISC.

Czym jest CISC?

CISC to angielski skrót od Complex Instruction Set Computing. Jest bardzo rozbudowana, dzięki czemu CPU typu CISC mogą wykonywać skomplikowane rozkazy, wymagające niestandardowych cykli zegara. Wyróżnia ją również to, że rozkazy nie muszą być przesyłane do rejestrów.

Są bardziej skomplikowane od procesorów RISC. Jeden rozkaz potrafi zawierać kilka prostych operacji do wykonania, przez co czasem są wolniejsze od RISC, lecz wykonanie jednej operacji zamyka się w mniejszej ilości cykli. Ma wspólną pamięć dla danych i instrukcji. Ich dodatkową zaletą jest kompatybilność z programami pochodzących z początku ery CISC, czyli 1981 roku.

Najpopularniejsze procesory CISC pochodzą z rodziny x86. Mają obecnie zdecydowanie największe udziały w rynku – produkowane są przez Intela i AMD, zaś używane w pecetach, laptopach, serwerach itd. Z racji na fakt operowania na 64 bitach oznaczane są obecnie jako x86-64, AMD64 lub x64.

Czym jest RISC?

RISC to skrót od angielskiego Reduced Instruction Set Computing. Zgodnie z nazwą, architektura RISC jest prostsza, co oznacza, że może wykonać mniejszą liczbę zadań. Była powszechnie wykorzystywana, ponieważ ok. 70% bardziej skomplikowanych rozkazów w architekturze CISC nie jest używanych – zazwyczaj procesory są zmuszone do wykonywania prostych operacji. Jej główną zaletą jest prostota – charakteryzuje się szybkim wykonywaniem prostych zadań, dzięki czemu radzi sobie lepiej z prostymi obliczeniami. Pamięć podręczna instrukcji i danych nie mogą być wspólne. Nie wymaga za to pamięci ROM (tylko do odczytu, służącej jako pamięć kontrolna).

RISC nie jest obecnie komercyjnie produkowane na szeroką skalę. Aktualnie wspierany jest przez publicznie dostępny RISC-V – model programowy prowadzony z myślą o prostych procesorach.

Low-power CPU

Low-power CPU to procesory, które mają celowo zmniejszoną moc obliczeniową w celu mniejszego poboru mocy. Skutkuje to mniejszymi temperaturami podczas działania CPU, z racji na brak dodatkowego chłodzenia. Dzięki temu jest stosowany z powodzeniem w urządzeniach pracujących na baterii, takich jak notebooki i e-booki.

Są coraz częściej wykorzystywane. We wrześniu 2020 roku powstała seria Intela pod nazwą Tiger Lake zajmująca się tworzeniem procesorów jedenastej generacji typu low-power. Wraz z miniaturyzacją i zapotrzebowaniem na kompaktowe laptopy, procesory te znajdują coraz szersze uznanie, pomimo celowo osiągniętej mniejszej wydajności.

Architektura CPU komputera

Na początku XXI w. przestano zwiększać zegar taktujący w pojedynczym rdzeniu procesora – zaczęto produkować procesory dwurdzeniowe, czyli składające się z większej liczby fizycznych części CPU, działające jako jeden procesor.

Procesor jednordzeniowy

Klasyczny procesor, używany powszechnie w komputerach przez cały XX wiek. Takie procesory zostały zastąpione procesorami wielordzeniowymi, ponieważ osiągnięto maksymalną ilość wykonywanych instrukcji na cykl. Procesory również miały tendencje do przegrzewania się.

Jego budowa powoduje, że może wykonywać jeden proces na raz. Sprawdza się to podczas wykonywania jednej, skomplikowanej operacji.

Multi CPU

Multi CPU oznacza działanie wielu procesorów jako jeden. Rozwiązanie tego typu stosowane jest w serwerach. Jest problematyczne ze względu na większe zużycie energii elektrycznej, jak i utrudnioną komunikację procesorów między sobą i pamięcią RAM. W Windowsie takie rozwiązanie nie jest wspierane przez wszystkie wersje systemu – w Windows 10 wymagana jest wersja Pro. Często oprogramowanie nie działa prawidłowo, wykorzystując tylko jeden rdzeń procesora.

Multi CPU nie znalazło powszechnego uznania w komputerach osobistych ze względu na wysokie koszty. Stosowany był głównie przez osoby potrzebujące dużej mocy obliczeniowej, np. zajmujące się obróbką video. Obecnie powszechnie stosowane są procesory wielordzeniowe.

Procesor wielordzeniowy (multi-core)

Jego główną zaletą jest możliwość przetwarzania wielu rozkazów naraz, przy mniejszym zużyciu energii niż jednordzeniowe i multi CPU. Multi-core używane są obecnie przez zdecydowaną większość urządzeń. Składają się z większej liczby rdzeni, czyli fizycznych części o oddzielnej mocy obliczeniowej składających się na CPU.

Do ciekawych rozwiązań technologicznych należy emulowanie dwóch rdzeni na jednym rdzeniu fizycznym – technologia ta została opracowana przez Intela i nazwana Hyper-Threading.

Faktyczna wydajność procesora dwurdzeniowego nie będzie zawsze dwukrotnością wydajności jednordzeniowego CPU. Wynika to z tego, że wiele aplikacji nie jest nadal przystosowane do wielowątkowych procesorów. Mimo wszystko procesory multi-core sprawdzają się lepiej podczas wykonywania wielu operacji w jednym czasie, ponieważ poszczególne rdzenie wykonają szybciej skomplikowane obliczenia, dzieląc je między sobą.

Czym jest połączenie komputerowe bus?

Połączenie bus jest nazywane popularnie magistralą komunikacyjną. Odpowiada za przekazywanie informacji pomiędzy danymi urządzeniami a układami znajdującymi się w komputerze, takimi jak CPU lub pamięć RAM (pamięci o swobodnym dostępie, pamięć operacyjna).

Magistrale składają się z trzech szyn, czyli grup linii odpowiedzialnych za przesyłanie określonych informacji. Wyróżniamy:

- Szynę adresową – wyznacza miejsce w pamięci, gdzie mają zostać przesłane dane

- Szyna sterująca – definiuje rodzaj operacji, czyli odczyt/zapis

- Szyna danych – przesyłane są nią dane, po przesłaniu powyższych informacji przez wspomniane szyny

Połączenia bus dzielą się na szeregowe i równoległe, zależnie od sposobu przesyłu sygnałów. Magistrale są również jednokierunkowe (z angielskiego simplex) lub dwukierunkowe (z angielskiego duplex).

Połączenia bus są ważne ze względu na to, że łączą ze sobą urządzenia wejścia/wyjścia (np. myszkę) i elementy znajdujące się na płycie głównej, sercu komputera.

Magistrale komunikacyjne – rodzaje USB

USB oznacza uniwersalną magistralę szeregową. Implementacja tego złącza odbyła się przy kooperacji wielu dużych informatycznych firm, dzięki czemu USB zostało powszechnie używanym standardem na świecie. Korzysta z niego większość urządzeń peryferyjnych podłączanych do komputera, takich jak telefony komórkowe, klawiatury, myszki, dyski zewnętrzne i przenośne itd. Można podłączyć wiele urządzeń do jednego komputera, nie wpływając negatywnie na ich funkcjonowanie.

Komputer automatycznie rozpoznaje urządzenia podłączane przez USB, nie wymagając przy tym od użytkownika informacji o nich. Technologia ta znana jest pod nazwą Plug and Play, zaproponowaną przez Microsoft.

Obecnie USB obejmuje wiele złączy. Szczególne są wtyki micro (przeznaczone głównie dla urządzeń mobilnych) i mini (starsze aparaty fotograficzne, ładowarki itd.)

Początki USB to rok 1998 i standard USB 1.1 z maksymalną prędkością 1.5 MB/s. Aktualnie używane są USB 3.2 o przepustowości 2.5GB/s, zaś prowadzone są prace na częściowo kompatybilnym wstecznie USB4.

SATA

Podobnie jak USB, SATA jest szeregową magistralą. Służy do umożliwienia komunikacji dysków twardych i innych nośników pamięci z komputerem poprzez szynę sterującą. W jego skład wchodzi 7 styków. Obecnie posługujemy się standardem SATA III o przepustowości 6 Gb/s.

W większości przypadków wejścia SATA różnych standardów są ze sobą kompatybilne. W tym celu niektórzy producenci spowalniają pracę dysków do 3 Gb/s przy użyciu zworki, czyli zwarcia ze sobą dwóch pinów.

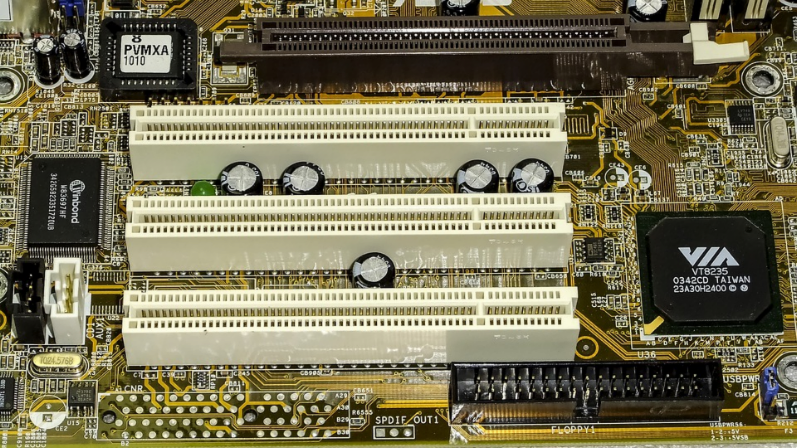

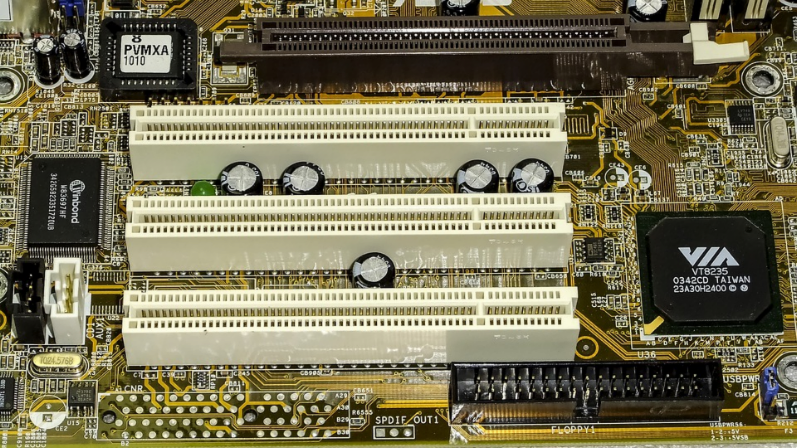

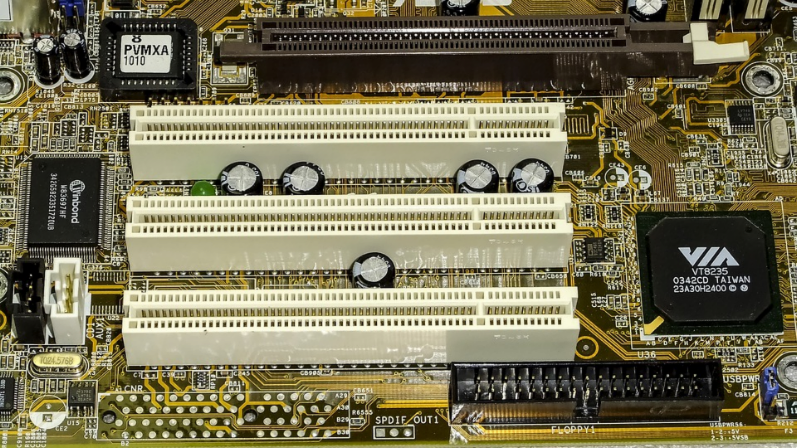

PCI Express

Jest wykorzystywanym powszechnie standardem do połączenia komputera z kartami rozszerzeń, czyli elementami posiadającymi charakterystyczne pozłacane styki wpinane bezpośrednio do wejść na płycie głównej. Jest następcą magistrali PCI. Jest to linia szeregowa z pełnym duplexem, czyli przekazywaniem danych przez cały czas trwania połączenia w obu kierunkach.

PCI Express składa się z wariantów o różnej ilości linii, będącymi kolejnymi potęgami dwójki – 1, 2, 4, 8 i 16. Obecnie używany jest standard PCI Express 4.0 o przepustowości prawie 2000 MB/s na jednej linii. Prowadzone są prace nad standardem 5.0 mogącym przesyłać sygnały z prawie dwukrotnie większą przepustowością.

Thunderbolt

Thunderbolt to standard przesyłu danych, opracowywany przez Intela i Apple od 2009 roku. Jest połączeniem sygnałów transferowanych w złączach PCI Express i DisplayPort, wraz z dodatkowym prądem stałym.

Pierwsze dwa standardy, oznaczone jako Thunderbolt 1 i Thunderbolt 2, korzystały z Mini Display port, zaś Thunderbolt 3 i 4 działają poprzez złącze USB-C. Prędkość przesyłania danych w najnowszych dwóch standardach wynosi 40 Gb/s, ponad dwa razy szybciej niż USB 3.2. Pozwala to na obsługę 4K i filmów 360°.

Jego przeznaczeniem jest uniwersalność, tak jak w przypadku USB. Różni się od niego tym, że pozwala na przesyłanie obrazu, dzięki czemu można ich używać do do podłączania monitorów. Nowsze standardy pozwalają na korzystanie zarówno z klasycznego USB.

Ze względu na swoje właściwości, takie jak możliwość zastępowania wielu złączy, jest powszechnie wykorzystywany w laptopach, szczególnie w MacBookach.

Thunderbolt postrzegany jest jako złącze przyszłości, lecz używany jest powszechnie już dziś. Wraz z rozwojem technologii i koniecznością zwiększenia prędkości przesyłania danych, jest to dobre rozwiązanie, ponieważ jest wstecznie kompatybilne z używanymi powszechnie sprzętami używającymi USB.

PC Card

PC Card to używane w latach 90. urządzenia wielkości karty kredytowej. Początkowo używane jako dodatkowa pamięć, następnie jako modem bądź karta sieciowa. Ostatni typ kart pozwalał na działanie jako dysk twardy. Jego zaletą było działanie w trybie hot plug, czyli możliwość swobodnego działania i odłączania podczas użytkowania urządzenia. Zostało zastąpione ExpressCardem w 2003r.

ExpressCard

ExpressCard to następca PC Card, stosowany głównie w notebookach. Pozwala na podłączenie m.in. dysków SATA, jak i USB 3.0. Było również używane przez wielu jako możliwość korzystania z Internetu, poprzez kabel ze złączem RJ-45 do karty lub użycia jako modem. Ich zaletą jest możliwość użycia USB 3.0 w starszych sprzętach, które nie mają wbudowanych nowszych USB. Często jest również wykorzystywane jako czytnik kart pamięci z aparatów fotograficznych.

Magazyn Pamięci – RAM

Czym jest RAM?

Pamięć RAM dosłownie oznacza pamięć o swobodnym dostępie, czyli każda komórka w pamięci jest dostępna. Jest zarówno główną pamięcią komputera, jak i pośrednikiem między pamięcią podręczną procesora a pamięcią masową (głównie dyskami HDD i SSD). Wszystkie aktualnie używane programy znajdują się w pamięci RAM. Z racji na sposób działania pamięć RAM jest zerowana wraz z wyłączeniem komputera, ponieważ nie przechowuje na stałe żadnych danych – zapamiętuje dane do momentu braku zasilania. Pamięć RAM stosowana jest również w kartach graficznych.

Wykorzystanie w systemie operacyjnym

System operacyjny przechowuje w pamięci RAM wszystkie procesy, jakie są aktualnie wykonywane. Podczas uruchamiania komputera, w pamięci RAM zaczytywane są dane pochodzące z dysku systemowego. Pamięć o swobodnym dostępie jest kluczowa dla komputera, ponieważ bez niej niemożliwe byłoby uruchomienie systemu.

Wykorzystanie jako bufor

Pamięć RAM może być z sukcesem wykorzystana jako bufor np. podczas kopiowania plików z jednego dysku na drugi. Z racji na charakter działania pamięci RAM pozwala to na szybsze przesłanie danych za pomocą zewnętrznych programów. Czas dostępu do pamięci operacyjnej jest nieporównywalnie krótszy od czasu dostępu dla dysków HDD i SSD.

Aby wykorzystać RAM jako bufor, należy wydzielić odpowiednią część pamięci RAM jako pamięć buforową.

Co to jest pamięć DRAM?

Pamięć DRAM to dynamiczna pamięć RAM. Na jeden bit przypada jeden kondensator. Wymaga odświeżania po określonym czasie, ponieważ kondensatory rozładowują się. Jest siedmiokrotnie wolniejsza od SRAM, lecz dane zajmują czterokrotnie mniejszą fizyczną powierzchnię. Cenowo atrakcyjniejsza jest pamięć DRAM, ze względu na prostą budowę.

Co to jest pamięć SRAM?

Pamięć SRAM w przeciwieństwie do DRAM została zaprojektowana tak, że dane pozostają w pamięci zawsze, gdy jest dostęp do zasilania – nie wymagają odświeżania. Pamięć tego typu nie używa kondensatorów, lecz zbudowana jest z tranzystorów. Układy wykorzystujące tranzystory (w tym przypadku przerzutnik) są szybsze i większe niż te z kondensatorów – z tego wynika różnica w tempie pracy i wielkości poszczególnych rodzajów pamięci.

Dysk twardy HDD/SSD

Czym jest pamięć permanentna?

Pamięć permanentna to pamięć, która jest zachowywana na nośniku na stałe. W przeciwieństwie do pamięci RAM nie wymaga stałego dostępu do prądu, aby dane były przechowywane. Dostęp do pamięci odbywa się przy użyciu połączenia komputerowego bus – SATA w przypadku dysków twardych lub USB dla pendrive’ów. Czas dostępu jest zależny od typu pamięci. Każdy typ pamięci permanentnej pozwala na swobodny zapis i odczyt danych. W pecetach jako pamięci stałej zazwyczaj używa się dysków HDD i SSD.

Co to jest HDD?

HDD to skrót od angielskiego hard disk drive, oznaczającego dysk twardy. Jego nazwa wzięła się od dyskietki, nazywaną dyskiem miękkim. Dane są zapisywane na wirującym magnetycznym talerzu poprzez głowicę, która zmienia natężenie pola magnetycznego. Dane zapisane na dysku HDD są nieulotne, lecz same dyski wrażliwe są na uszkodzenia mechaniczne. Są również bardzo wrażliwe na pole elektromagnetyczne – zabawy magnesami w jego sąsiedztwie bardzo często kończą się częściowym lub całkowitym uszkodzeniem dysku.

Ich atutem jest możliwość łączenia dysków w macierze dyskowe, czyli współpraca wielu fizycznych dysków będąc jednocześnie jednym dyskiem w systemie. Pozwala to tworzyć grupy RAID, czyli grupy współpracujących dysków zwiększając wydajność i niezawodność.

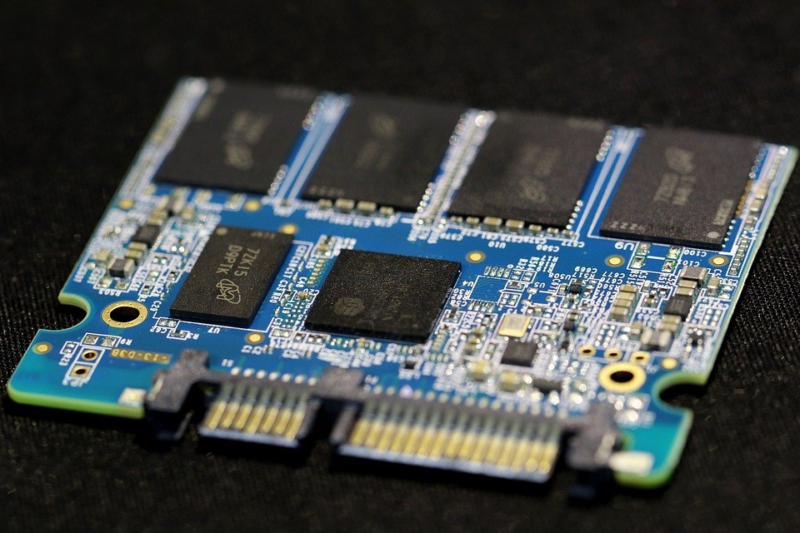

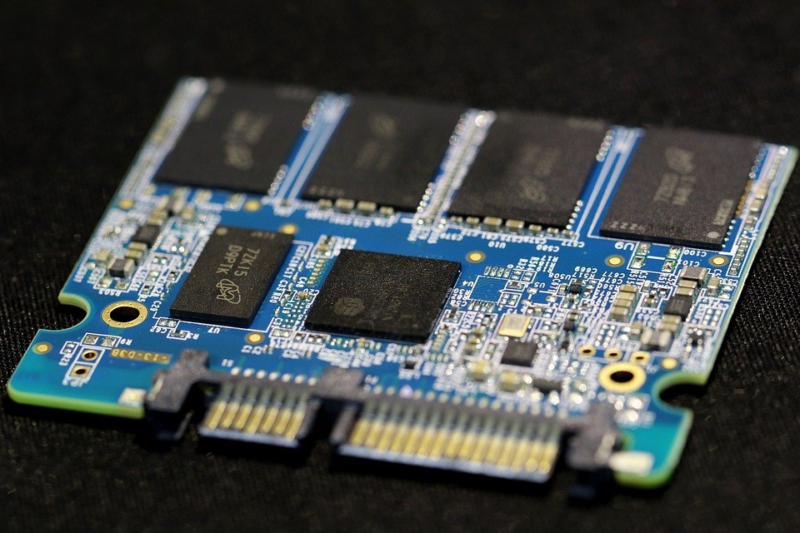

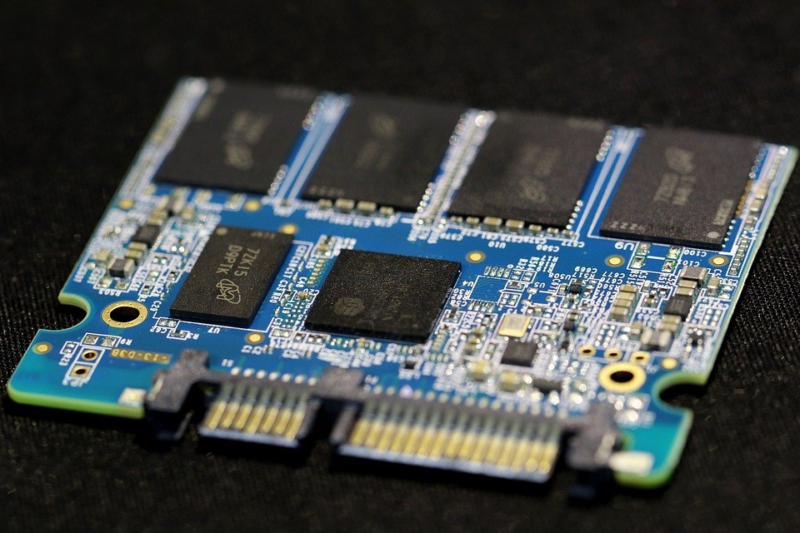

Co to jest SSD?

SSD to pamięć zbudowana z półprzewodników, nie zawierające ruchomych i magnetycznych części. Są odporne na uszkodzenia mechaniczne. Często nazywany dyskiem twardym, jest faktycznie rodzajem pamięci flash, używanej w pendrive’ach i kartach pamięci (np. SD).

Zasada działania polega na zapisywaniu danych przy użyciu bramek NAND lub NOR, zbudowanych z tranzystorów. Obecnie popularne są dyski wykorzystujące złącze M.2, pozwalające na miniaturyzację pamięci przy zachowaniu odpowiedniej prędkości.

Co różni HDD i SSD?

SSD jest mniejsze i szybsze od dysków HDD. Dyski twarde są jednak o wiele bardziej pojemniejsze od swoich półprzewodnikowych odpowiedników. SSD są odporniejsze na skrajne temperatury i fizyczne uszkodzenia, zużywają mniej prądu. Są cichsze i o wiele szybsze od HDD.

Ze względu na wspomniane parametry, użytkownicy PC często używają dysku SSD jako dysku systemowego (szybszy czas reakcji powoduje zredukowanie czasu uruchamiania komputera), zaś dysków twardych jako miejsce do trzymania dużych plików.

Zdecydowanym atutem dysków HDD jest mniejsza cena niż pamięci SSD.

Do czego jest wykorzystywany dysk twardy?

Dysk twardy to gwarancja bezpiecznego przechowywania danych, lecz trzeba zawsze pamiętać o robieniu kopii zapasowych. Ze względu na magnetyczny zapis, dyski twarde są w stanie pomieścić wiele danych. Dyski HDD nadal znajdują powszechne uznanie wśród wielu codziennych użytkowników, nie mających zapotrzebowania na najszybszy możliwy sprzęt na rynku. Jeden pojemny dysk HDD potrafi służyć niektórym za całą pamięć permanentną komputera.

Czym jest firmware?

Firmware to podstawowe oprogramowanie zainstalowane w urządzeniach elektronicznych. Nie jest tak rozbudowane jak system operacyjny. W razie potrzeby może zostać zaktualizowane. Z reguły firmware jest domyślnie zainstalowany i jest stworzony stricte do danego modelu urządzenia, pozwalając mu na prawidłowe działanie. Znajduje się zarówno w routerach, nagrywarkach DVD, jak i konsolach do gier lub telewizorach. W komputerach jego rolę pełni BIOS, czyli Podstawowy System Wejść i Wyjść (Basic Input Output System).Jego następcą jest UEFI (Unified Extensible Firmware Interface).

Bardzo ważny w firmwarze jest IPL, czyli Initial Program Loader. Odpowiada za zainicjowanie działania systemu operacyjnego, którego niezbędne elementy w funkcjonowaniu są przenoszone do pamięci operacyjnej (RAM). W komputerach stacjonarnych jego odpowiednikiem jest bootowanie systemu – czyli uruchamianie go po raz pierwszy od momentu wyłączenia zasilania.

Czym jest ROM?

Pamięć ROM to pamięć tylko do odczytu (Read Only Memory). W niej przechowywany jest firmware. Nie może być zmodyfikowana. Jest pamięcią stałą, czyli dane są przechowywane niezależnie od napięcia lub jego braku. Dzieje się to za sprawą baterii, która podtrzymuje dostęp do zasilania.

Na pamięci ROM w komputerze działa wspomniany BIOS, który odpowiada m.in. za urządzenia wejścia/wyjścia.

Czym jest PROM?

PROM to programowalny ROM. Domyślnie jej wszystkie wartości to 1. Jej programowanie odbywa się za pomocą przepalania drucików – brak połączenia to 0, połączenie to 1.

Ze względu na to, że jest to pamięć tylko do odczytu, można zaprogramować ją tylko raz. Przeznaczona jest głównie dla osób, które na co dzień zajmują się elektroniką, ponieważ bardzo trudno ją odpowiednio skonfigurować.

Czym jest EPROM?

EPROM to bardziej zaawansowana wersja PROMu. Składa się z dwóch bramek działających na tranzystorach. Programuje się ją za pomocą dostarczenia dużego napięcia, które przechodzi z bramki sterującej do pamiętającej.

Może zostać wykasowana za pomocą promieni UV. Służy do tego specjalne okienko ze szkła kwarcowego, które powinno być zasłonięte dla prawidłowego działania.

Czym jest EEPROM?

Pamięć EEPROM (Electronic EPROM) różni się od EPROM tym, że można ją programować i kasować elektronicznie. Uszkodzenie pamięci następuje jedynie na skutek kasowania – zapis jest nieograniczony. Na jeden bit przypadają dwa tranzystory. Może być programowany będąc na płycie głównej lub w innym układzie.

Pamięć ta używana jest w kartach SIM i kartach kredytowych. Zastąpiła wcześniej wspomniane typy pamięci ROM.

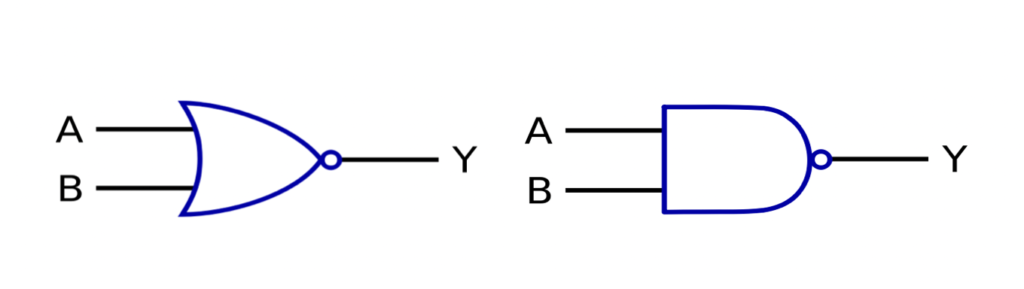

Co to jest pamięć flash?

Pamięć flash to bardziej skomplikowana wersja EEPROM. Składa się z bramek logicznych – NOR (od lewej) i NAND (po prawej).

NAND potrzebuje mniej czasu na kasowanie i zapisywanie danych. Pamięć flash typu NAND jest wytrzymalsza i tańsza od flash NOR, dlatego jest powszechnie używana w kartach pamięci i pendrive’ach. Wykorzystują ją również wspomniane SSD.

Czym są urządzenia I/O?

Urządzenia I/O (Input/Output) to urządzenia wejścia-wyjścia, które pozwalają użytkownikowi na interakcję z komputerem. Należą do nich urządzenia peryferyjne, czyli nie będące częścią komputera, lecz dodatkowymi urządzeniami służącymi do jego obsługi.

Przykładowe urządzenia I/O to mysz, klawiatura, mikrofon, monitor, głośniki, karta sieciowa lub kamera internetowa. Podłączane są do komputera za pomocą magistrali komunikacyjnych, zazwyczaj USB. Obsługą takiego urządzenia zajmuje się system operacyjny.

Architektura wielu komputerów

Czym są blade computers?

Blade computers to małe komputery, znajdujące się zazwyczaj w jednej szafie rack lub specjalnej obudowie. Urządzenia I/O zazwyczaj podłączane są do nich poprzez sieć lokalną.

Takie rozwiązanie pozwala na fizyczne zablokowanie dostępu użytkownikom do portów USB, zwiększając bezpieczeństwo. Dzięki temu wiele pecetów może znajdować się w jednym miejscu, które jest odpowiednio strzeżone przed niepowołanymi osobami. Ułatwia to również przeprowadzanie napraw, polegających na wymianie poszczególnego blade’a. Może to się dokonać bez wyłączania zasilania dla blade’ów.

Czym są grid computers?

Grid computers to komputery, które dzielą zasoby ze sobą w ramach jednej sieci. Jest rozszerzonym pojęciem klastra, czyli komputerów które dzielą ze sobą moc obliczeniową. Zaletą komputerów w pracujących w systemie grid jest to, że nie muszą znajdować się fizycznie obok siebie. Mogą również różnić się np. topologiami sieci.

Głównymi zarządcami są Wirtualne Organizacje (VO). Pozwalają na kontrolowanie tego, jak komputery wykorzystują wspólne zasoby. Użytkownik gridu zazwyczaj nie ma dostępu do tego, w jaki sposób zlecone przez niego zadania są rozlokowane po poszczególnych urządzeniach. O jakości usług decyduje QoS (Quality of Service), który odpowiada za nadawanie priorytetów.

Co to jest klaster serwerów?

Wiele serwerów, widocznych w systemie jako jeden, tworzy klaster. Ich głównym zadaniem jest utrzymanie serwerów WWW, które w klasycznej architekturze klient-serwer bywają przeciążone. Klaster jednocześnie odciąża sieć, jak i pozwala na niezawodne działanie serwera widzianego w systemie.

Bardzo często jako klaster działa wiele komputerów osobistych z systemami linuksowymi. Zarządza nimi protokół umożliwiający jednoczesne przetwarzanie danych.

Architektura wirtualizacji

Wirtualizacja polega na użyciu maszyn wirtualnych (VM), które w pełni wykorzystują sprzęt komputerowy. Na jednym urządzeniu może działać wiele wirtualnych systemów, które mogą być przywrócone z uprzednio zapisanego obrazu systemu – dzięki temu nie ma konieczności instalowania danego systemu, lecz przywraca się go z pliku. Wszystkie dane znajdują się na serwerach, zamiast na stacjach roboczych, co znacząco wpływa na bezpieczeństwo.

Za dostęp maszyn do fizycznych zasobów odpowiadają hiperwizory, czyli oprogramowanie zajmujące się pracą maszyn wirtualnych. Dzięki nim maszyny znajdują wolny rdzeń procesora i nie przerywają pracy innym maszynom.

Wirtualne maszyny są widoczne przez resztę urządzeń jako te, których role spełnia VM. Przykładowo, wirtualny system Ubuntu będzie widoczny dla innych urządzeń jako faktyczna dystrybucja Linuksa.

Wirtualizacja znacząco redukuje koszty – pozwala użyć wirtualnego oprogramowania na danym hardwarze zamiast fizycznego kupowania sprzętu z zainstalowanym systemem. Zmiana software’u bądź konieczność zamiany na inny również jest uproszczona, ponieważ administrator nie musi fizycznie zmieniać ustawień urządzenia.

Zagrożenia w wirtualizacji

- Dostęp w wirtualizacji – dostęp do wirtualnych maszyn odbywa się zazwyczaj za pomocą sieci lokalnej lub Internetu, dlatego trzeba odpowiednio zadbać o zabezpieczenie sieci przed niepowołanymi osobami

- Alokacja zasobów fizycznych – nieodpowiednie zarządzanie zasobami może spowodować znaczący spadek wydajności

- Monitorowanie – dzięki możliwościom monitoringu wykorzystywania zasobów przez danych użytkowników można zapobiec wyciekom wrażliwych danych.

- Hardening – odpowiednie zarządzanie dostępem do zasobów dla osób o różnym typie konta, tj. goście, użytkownicy itd. Polega również na dzieleniu dostępu na różne strefy jak i na odpowiednim uwierzytelnianiu się zalogowanych osób.

System operacyjny

System operacyjny (OS) służy jako pomost między użytkownikiem a komputerem. Odpowiada on również za kontrolowanie zadań w pamięci RAM i przydzielanie zadań dla CPU. Przetwarza on wiele procesów na raz, kontrolując zadania wykonywane przez hardware (fizyczne części komputera). Do prawidłowego działania komputera powinien być zainstalowany odpowiedni OS.

Korzystając z peceta, operujemy na systemie operacyjnym. Każda nasza czynność, od momentu poprawnego rozruchu systemu, wykonywana jest za jego pomocą.

Aktualnie najwięcej komputerów korzysta z systemów windowsowych. Na urządzeniach mobilnych króluje Android, będący systemem linuksowym dostosowanym do smartfonów.

Systemy składają się z 3 części:

- Jądro – odpowiada za komunikację z CPU, planując jego zadania.

- Powłoka – wszystko, co widzi na ekranie monitora użytkownik korzystający z komputera. Jego zadaniem jest przetwarzanie poleceń użytkownika

- System plików – odpowiada za zapisywanie danych na pamięci permanentnej w odpowiednim formacie

Obsługiwane przez OS:

- Dostęp do urządzeń peryferyjnych – urządzenia tego typu pozwalają użytkownikowi na sprawne poruszanie się w systemie, np. za pomocą myszki i klawiatury. Dostęp do urządzeń peryferyjnych pozwala systemowi na wykonywanie poleceń, np. poprzez ruchy myszki lub wpisywanie odpowiednich komend

- Zarządzanie storage – dzięki systemowi możemy zarządzać przestrzenią dyskową. Można wygodnie tworzyć partycje, jak i zmieniać lokalizacje plików.

- Zarządzanie procesami – system jest odpowiedzialny za kontrolę nad procesami, które przetwarzane są w CPU bądź pamięci RAM

- Alokacja zasobów – procesy wysyłane do CPU mają nadawane odpowiednie priorytety przez system

- Komunikacja (sieć, urządzenia I/O) – połączenie z siecią, jak i prawidłowe działanie urządzeń peryferyjnych to jedne z wielu zadań OS. W systemie konfigurowany jest adres IP, dzięki któremu urządzenie może się komunikować. Urządzenia wejścia/wyjścia są potrzebne do obsługi systemu.

- Bezpieczeństwo – nasze dane powinny być chronione nie tylko przez klucze szyfrujące (np. U2F), lecz powinniśmy zwracać uwagę również na działanie zapory ogniowej (firewall) lub aktualność systemu. Starsze systemy są bardziej podatne na różne ataki, ze względu na brak łatek. W nowszych systemach możemy skutecznie zabezpieczyć się przed niechcianymi działaniami poprzez wbudowane opcje, np. Windows Defender.

Pliki systemowe

Pliki systemowe odpowiadają za prawidłowe działanie systemu. Są bardzo wrażliwymi plikami, dlatego nie warto na nich eksperymentować. Domyślnie są ukryte. Zazwyczaj są bardzo trudne w usunięciu, ze względu na ich wagę dla systemu.

Struktura plików

Pliki tworzą strukturę na kształt drzewa. Tworząc folder, możemy stworzyć w nim kolejne, które będą zawierały pliki.

Czym są foldery?

Folder nazywany jest „komputerową teczką”. Pozwala na odseparowanie danych i przechowywanie ich w określonych miejscach. Znacznie ułatwia segregowanie danych, ponieważ na jednym fizycznym dysku może znajdować się wiele folderów.

Czym są pliki?

Plik to określone dane, zapisane w odpowiednim rozszerzeniu. Ich poprawne otworzenie wymaga konkretnego oprogramowania. Każdy plik zajmuje miejsce w pamięci. Każdy plik charakteryzuje się różnymi cechami. Sposób, w jaki są zapisywane i przechowywane, definiuje system plików (file system).

Lista znanych file system

- FAT – system stosowany w systemach windowsowych. Pliki znajdują się w tablicy określającej ich położenie na partycji.

- NTFS – skomplikowany system w systemach windowsowych, odporniejszy na błędy niż FAT. Dysk jest dzielony na klastry. Metadane są przechowywane w tablicy MFT (Master file table).

- Ext3 – linuksowy system plików, używany dla wersji jądra 2.4-2.6

- Ext4 – linuksowy system plików, wstecznie kompatybilny z ext3. Używany powszechnie od końca 2008 roku.

- ReiserFS – system plików będący w jądrze Linuksa, do czasów pojawienia się Ext3

- XFS – przeznaczony jest głównie do obsługi wielu dużych plików, pisany dla systemów UNIXowych

- JFS – stworzony przez IBM 64-bitowy system plików

- HFS – system plików stworzony dla systemów od Apple, będący standardem w latach 1985-1998

- APFS – wdrożony w 2017 roku system plików dla systemów z rodziny Apple. Ma bardzo rozbudowane szyfrowanie.

- ReFS – przeznaczony jest dla systemów typu Windows Server

- ISO/IEC 9660 – wprowadzony przez ISO system plików, obsługiwany przez systemy uniksowe, Mac OS i systemy windowsowe. Jest przeznaczony dla płyt CD.

- UDF – następca ISO/IEC 9660, przeznaczony m.in. dla Blu-Ray i DVD.

Podsumowanie

Architektura sprzętowa komputera to skomplikowane zagadnienie, które zahacza o wiele dziedzin. Artykuł miał na celu opisanie najważniejszych elementów, jak i skupienie się na szczegółach.

Mam nadzieję, że tekst pomógł rozjaśnić pewne trudne terminy.

Pozdrawiam – Oskar

The form you have selected does not exist.